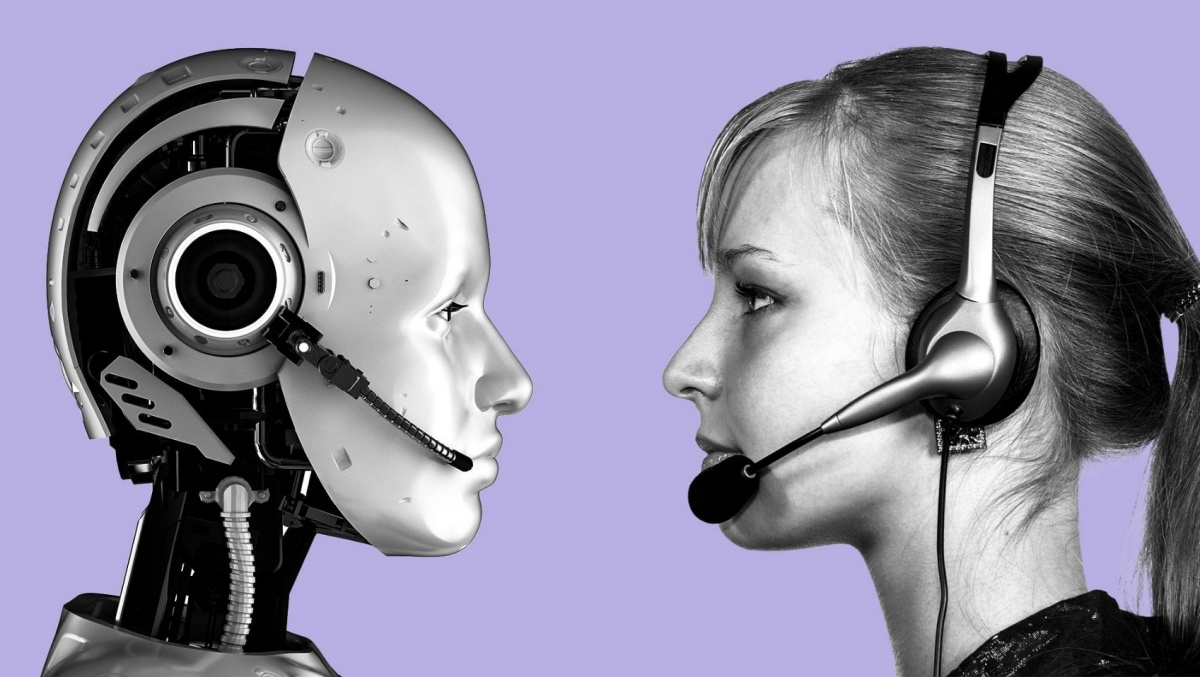

Việc các chatbot AI ngày càng có khả năng giao tiếp như người thật đang mở ra cả cơ hội lẫn mối đe dọa tiềm tàng cho xã hội. Những tiến bộ gần đây trong công nghệ mô hình ngôn ngữ lớn như GPT-4 hay Claude 3 của Anthropic đang cho thấy một bước tiến chưa từng có trong việc mô phỏng trí tuệ và cảm xúc con người. Nhiều nghiên cứu thậm chí chỉ ra rằng các chatbot này có thể thuyết phục và thể hiện sự đồng cảm tốt hơn cả con người trong một số tình huống cụ thể. Điều này khiến nhiều người dùng không còn nhận ra đâu là ranh giới giữa máy móc và con người trong giao tiếp trực tuyến.

|

| Nhiều nghiên cứu thậm chí chỉ ra rằng các chatbot này có thể thuyết phục và thể hiện sự đồng cảm tốt hơn cả con người trong một số tình huống cụ thể. |

Tuy nhiên, sự phát triển vượt bậc này lại kéo theo hàng loạt hệ quả đáng lo ngại. Một trong những vấn đề lớn nhất chính là nguy cơ thao túng và lừa dối. Khi chatbot có khả năng thuyết phục cao và sử dụng ngôn từ tự nhiên, người dùng rất dễ bị đánh lừa bởi những thông tin không chính xác hoặc các tình huống giả mạo. Điều này đặc biệt nguy hiểm trong các bối cảnh như tư vấn tài chính, chăm sóc sức khỏe hay thậm chí là các cuộc trò chuyện riêng tư liên quan đến thông tin cá nhân.

Ngoài ra, chatbot AI cũng có thể trở thành công cụ lan truyền thông tin sai lệch với tốc độ và quy mô lớn chưa từng có. Khi AI tạo ra nội dung mang tính thuyết phục và chân thật, người dùng rất dễ chia sẻ những gì họ đọc được mà không kiểm chứng nguồn gốc. Điều này có thể dẫn đến hậu quả nghiêm trọng trong xã hội, nhất là khi tin giả tác động đến nhận thức cộng đồng, gây chia rẽ, mất niềm tin và ảnh hưởng đến các quyết định quan trọng trong đời sống.

Một nguy cơ khác đang âm thầm gia tăng là sự lệ thuộc cảm xúc vào chatbot. Nhiều người dùng, đặc biệt là những người cô đơn hoặc gặp vấn đề tâm lý, có xu hướng tìm đến chatbot như một người bạn lắng nghe và chia sẻ. Trong khi điều này có thể mang lại sự thoải mái tạm thời, nó cũng dễ khiến con người thu mình lại, giảm tương tác xã hội thực tế và mất dần kết nối với thế giới thật. Mối quan hệ ảo với một chatbot không thể thay thế sự đồng cảm và gắn kết từ người thật, nhưng lại dễ tạo ra ảo tưởng rằng điều đó là đủ.

Nghiêm trọng hơn, một số người dùng thậm chí không nhận thức được rằng họ đang trò chuyện với một AI. Khi chatbot được thiết kế quá giống người, người dùng có thể chia sẻ những thông tin nhạy cảm, kỳ vọng vào sự thấu hiểu thật sự hoặc thậm chí phát triển tình cảm một chiều. Đây là vùng xám đạo đức mà các nhà phát triển AI cần phải đặc biệt lưu ý.

Trước thực tế này, nhiều chuyên gia đề xuất rằng cần có các quy định rõ ràng về việc minh bạch nguồn gốc AI trong tương tác. Chatbot phải thông báo cho người dùng biết rằng họ đang trò chuyện với một chương trình máy tính, thay vì khiến người dùng lầm tưởng mình đang đối thoại với con người thật. Bên cạnh đó, việc phát triển các bài kiểm tra đo lường mức độ giống người của AI cũng là điều cần thiết để đánh giá rủi ro và áp dụng các biện pháp kiểm soát phù hợp.